请启用 JavaScript 并禁用任何广告拦截器。

每日HackerNews RSS

气象局(BOM)最近推出的网站重新设计引发了重大争议,原因是其成本高昂——超过9600万澳元,与最初宣称的400万澳元形成鲜明对比——并且存在可用性问题。在广泛的投诉之后,特别是来自农民,他们难以通过修改后的雷达地图获取关键降雨数据,政府介入,强制恢复旧雷达地图并持续对网站进行调整。 气象局为这笔费用辩护,称这是为了满足现代安全和可访问性要求而进行的“完全重建”。然而,环境部长默里·瓦特已指派新的气象局首席执行官斯图尔特·明金调查该项目成本如何飙升以及为何未能满足公众期望。他预计会收到一份关于问题及其原因的完整报告。 反对派人士将该项目称为“灾难”,强调了获取本地化数据受限带来的风险。气象局表示,它正在积极响应社区反馈并实施进一步改进,但由于当前的天气事件,一些更新已暂停。

## Outcrop:构建下一代知识库

Imed 正在构建 Outcrop,一个专注于**速度和简洁性**的 Confluence 替代方案。这个项目源于他在 Stripe 工作期间对现有解决方案的 frustation。他意识到,一个真正更好的知识库需要快速搜索、轻松协作和自动化维护。

该项目最初用 Go 快速构建了一个原型,很快就发现需要一个更强大的基础。他最终选择了 **Rust**,因为它具有高性能和强大的工具,并构建了关键组件,例如受 Zanzibar 启发的授权系统(用于细粒度权限)和利用 `tantivy` 的自定义搜索引擎。他甚至将协作编辑器 Prosemirror 移植到 Rust,以克服性能限制。

Outcrop 优先考虑实时协作,将授权直接集成到搜索中,并旨在超越简单的文本,未来可能支持图表、工作流程以及与任务管理工具的集成。目前 Outcrop 正在开发中,计划在六个月内发布,价格为每席 €/$10,并提供赞助机会。

更多信息和加入候补名单,请访问 [outcrop.app](https://outcrop.app)。

## Outcrop:构建下一代知识库

Imed 正在构建 Outcrop,一个专注于**速度和简洁性**的 Confluence 替代方案。这个项目源于他在 Stripe 工作期间对现有解决方案的 frustation。他意识到,一个真正更好的知识库需要快速搜索、轻松协作和自动化维护。

该项目最初用 Go 快速构建了一个原型,很快就发现需要一个更强大的基础。他最终选择了 **Rust**,因为它具有高性能和强大的工具,并构建了关键组件,例如受 Zanzibar 启发的授权系统(用于细粒度权限)和利用 `tantivy` 的自定义搜索引擎。他甚至将协作编辑器 Prosemirror 移植到 Rust,以克服性能限制。

Outcrop 优先考虑实时协作,将授权直接集成到搜索中,并旨在超越简单的文本,未来可能支持图表、工作流程以及与任务管理工具的集成。目前 Outcrop 正在开发中,计划在六个月内发布,价格为每席 €/$10,并提供赞助机会。

更多信息和加入候补名单,请访问 [outcrop.app](https://outcrop.app)。

这系列博客文章,主要发表于2022-2025年间,详细分析了IETF和NIST后量子密码学(PQC)标准化的过程,指控其中存在美国国家安全局(NSA)的影响和流程缺陷。作者认为NSA正在通过操纵IETF的共识构建程序,推动标准化强度不足的“非混合”密码学(仅PQC,不含ECC)。 主要担忧包括指控投票结果被篡改、异议被忽视,以及“共识”的定义被改变以强行通过NSA偏好的方案。作者认为这优先考虑国家安全利益而非强大的安全性,可能导致系统存在漏洞。他们强调了流程仓促、对Kyber-512等算法的安全分析存在疑问,以及缺乏透明度等问题。 进一步的批评还包括NIST的标准化流程、PQC算法的专利问题,以及IETF内部更广泛的审查和正当程序问题。作者详细描述了一个正式的投诉流程,据称被阻挠并最终以程序漏洞被驳回。核心论点是,目前的路径由于政治影响和有缺陷的技术决策,可能损害互联网安全。

arXivLabs是一个框架,允许合作者直接在我们的网站上开发和分享新的arXiv功能。个人和与arXivLabs合作的组织都认同并接受我们开放、社群、卓越和用户数据隐私的价值观。arXiv致力于这些价值观,并且只与秉持这些价值观的合作伙伴合作。您是否有为arXiv社群增加价值的项目想法?了解更多关于arXivLabs的信息。

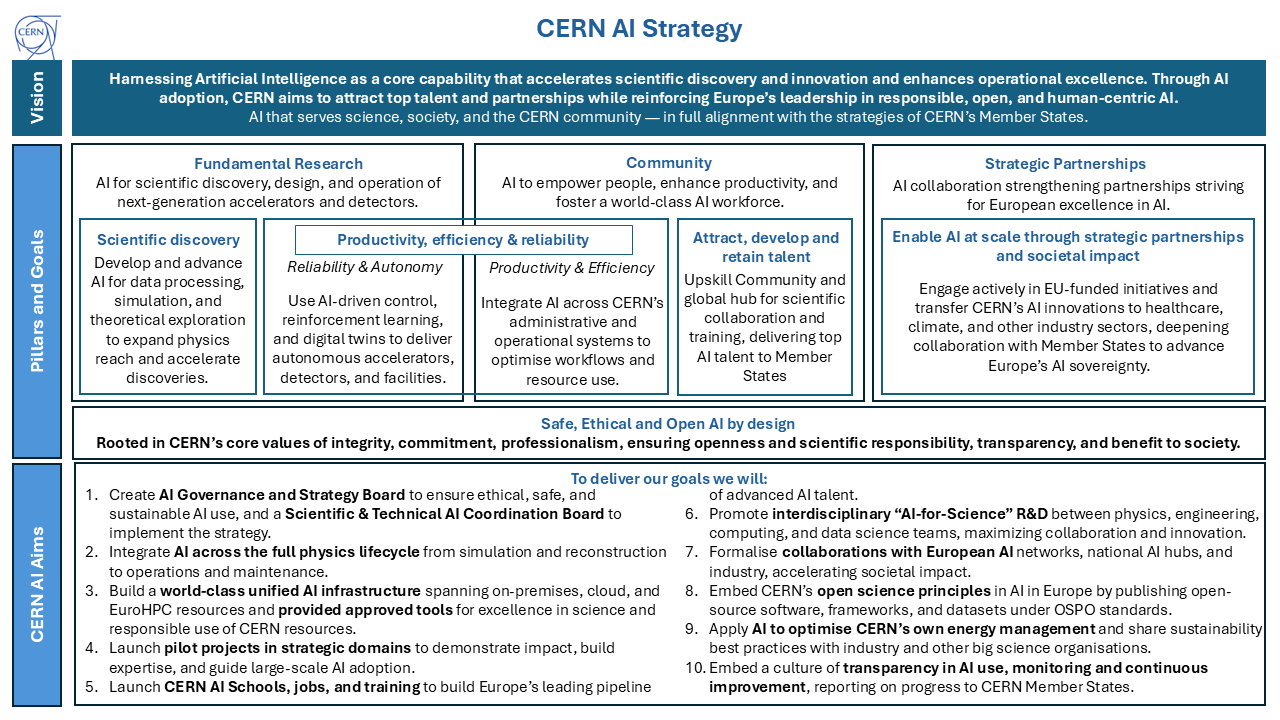

欧洲核子研究中心(CERN)已建立指导原则,以负责任的方式在所有活动中使用人工智能(AI),涵盖科学研究(数据分析、加速器优化)到行政任务(自动化、翻译)。这些原则不依赖于特定技术,适用于CERN使用的所有AI技术,无论是由内部开发还是外部采购。

关键原则包括**透明度**——清晰记录AI的作用——以及始终保持**人类责任与监督**。AI的使用必须**合法、公平、无歧视**,并优先考虑**安全**,防止损害和网络安全威胁。

此外,CERN强调**可持续性**,旨在最大限度地减少环境影响,并严格遵守**数据隐私**。至关重要的是,所有AI应用仅限于**非军事目的**。这些原则旨在利用AI的潜力,同时维护CERN的道德标准,并确保其益处符合社会公益。

欧洲核子研究中心(CERN)已建立指导原则,以负责任的方式在所有活动中使用人工智能(AI),涵盖科学研究(数据分析、加速器优化)到行政任务(自动化、翻译)。这些原则不依赖于特定技术,适用于CERN使用的所有AI技术,无论是由内部开发还是外部采购。

关键原则包括**透明度**——清晰记录AI的作用——以及始终保持**人类责任与监督**。AI的使用必须**合法、公平、无歧视**,并优先考虑**安全**,防止损害和网络安全威胁。

此外,CERN强调**可持续性**,旨在最大限度地减少环境影响,并严格遵守**数据隐私**。至关重要的是,所有AI应用仅限于**非军事目的**。这些原则旨在利用AI的潜力,同时维护CERN的道德标准,并确保其益处符合社会公益。

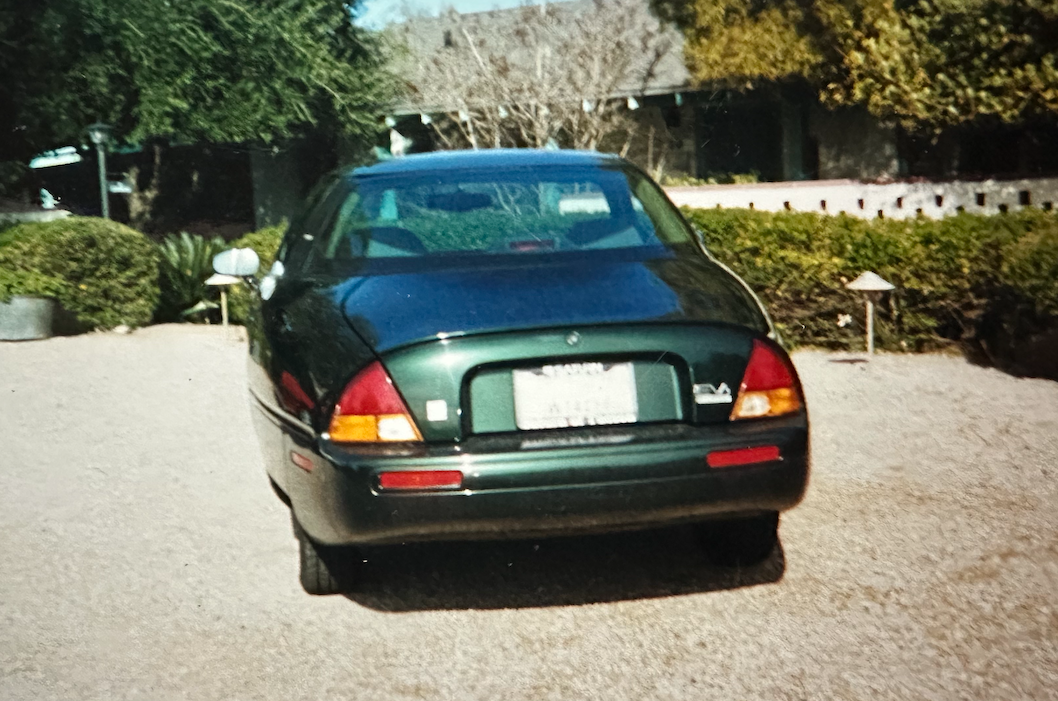

## EV1 的意外复活

通用汽车的 EV1,第一款量产电动汽车,在 90 年代末大部分被停产并被压碎。然而,车辆识别码为 4G5PX2250V0200212 的 EV1 逃脱了这种命运。它于 1997 年最初被租赁,与通用汽车的法律斗争使原始租赁者避免了他的汽车被销毁,但最终却被遗弃在亚特兰大的拖车场。

值得注意的是,这辆 EV1 最近成为*第一辆*合法售予公众的汽车,在拍卖会上以 118,000 美元的价格成交。尽管它年代久远且状况不佳——缺少电池并有一些损坏——但新的车主,一位狂热的电动汽车爱好者,计划进行全面修复。

EV1 虽然续航里程有限,仅为 90 英里,马力为 137,但在当时具有开创性意义,拥有令人难以置信的空气动力学设计(阻力系数为 0.19——优于现代电动汽车)以及再生制动等功能。它的幸存归功于一位坚定的车主和一点法律上的运气,提供了一个重现汽车历史的一部分的独特机会。修复工作正在进行中,目标是在 2026 年它的 30 周年时让汽车重新运行,这得益于一个充满激情的社区和一个对这款先锋电动汽车共同的热爱。

## EV1 的意外复活

通用汽车的 EV1,第一款量产电动汽车,在 90 年代末大部分被停产并被压碎。然而,车辆识别码为 4G5PX2250V0200212 的 EV1 逃脱了这种命运。它于 1997 年最初被租赁,与通用汽车的法律斗争使原始租赁者避免了他的汽车被销毁,但最终却被遗弃在亚特兰大的拖车场。

值得注意的是,这辆 EV1 最近成为*第一辆*合法售予公众的汽车,在拍卖会上以 118,000 美元的价格成交。尽管它年代久远且状况不佳——缺少电池并有一些损坏——但新的车主,一位狂热的电动汽车爱好者,计划进行全面修复。

EV1 虽然续航里程有限,仅为 90 英里,马力为 137,但在当时具有开创性意义,拥有令人难以置信的空气动力学设计(阻力系数为 0.19——优于现代电动汽车)以及再生制动等功能。它的幸存归功于一位坚定的车主和一点法律上的运气,提供了一个重现汽车历史的一部分的独特机会。修复工作正在进行中,目标是在 2026 年它的 30 周年时让汽车重新运行,这得益于一个充满激情的社区和一个对这款先锋电动汽车共同的热爱。

(Empty input provided. There is nothing to translate.)

## Google Kubernetes Engine (GKE) 扩展以支持 AI 工作负载 – 摘要 Google Cloud 正在积极扩展 Google Kubernetes Engine (GKE),以满足日益复杂的 AI 工作负载需求。他们已成功测试了一个 **130,000 节点集群**,是官方支持限制的两倍,维持 **每秒 1,000 个 Pod**,并管理超过 100 万个存储对象。 这一推动源于已经运行在 20-65K 节点范围内的客户,预计需求将稳定在 100K 节点左右。然而,扩展到超出这个范围带来了新的挑战,主要在于 **功耗**,因为 AI 芯片(如 NVIDIA GB200s)需要大量的能源。这需要强大的 **多集群解决方案**,通过 MultiKueue 等工具和像托管 DRANET 这样的高级网络进行编排。 实现这种规模的关键创新包括通过改进的 API 服务器缓存实现 **优化的读取可扩展性**,基于 Spanner 构建的 **高性能分布式存储后端**,以及 **Kueue** 用于高级作业队列。未来的开发重点是 Kubernetes 本身中的 **工作负载感知调度**,以及通过 **Cloud Storage FUSE** 和 **Managed Lustre** 等解决方案实现高效的数据访问。 这些改进不仅使大型用户受益,还提高了所有 GKE 集群的弹性和性能,无论其规模如何。

我们正在验证您的浏览器。网站所有者?点击此处修复。 Vercel 安全检查点 | sin1::1763976852-GSYlGE91jYU4iSO3QeNZvoatthfSqUVa 启用 JavaScript 以继续。 Vercel 安全检查点 | sin1::1763976852-GSYlGE91jYU4iSO3QeNZvoatthfSqUVa