每日HackerNews RSS

谚语“出头的椽子先被钉”和“会叫的轮子得到润滑”说明了对与众不同或有需求的不同反应。虽然两者都涉及较大系统中的“缺陷”元素,但一个面临压制,另一个获得关注。 作者反思了这些隐喻,特别是作为那些不善于自我倡导的人。他们强调,问题的紧迫性与元素的重要性相关——一个失灵的轮子比一颗弯曲的钉子更能阻碍功能。有效的倡导需要*适度地*传达紧迫性,并*清晰地*提出解决方案请求。 然而,“钉子”也有价值。有时,勇敢地指出根本性的缺陷——即使付出个人代价——也是必要的。如果足够多的“钉子”发声,系统性问题可能会得到解决。关键在于辨别*何时*提出问题,尽可能提供解决方案,并在问题严重时保持坚定,即使这意味着面临阻力。

## Guts:前往 TypeScript 代码生成

Guts 是一个 Go 库,旨在将 Go 类型转换为 TypeScript,从而在前端和后端之间保持类型一致性。与命令行工具不同,Guts 优先考虑程序化配置和自定义,允许开发者通过代码定制转换过程。

该过程涉及解析 Go 包,遍历其抽象语法树 (AST),并将 Go 类型映射到等效的 TypeScript AST 表示。然后,Guts 利用官方 TypeScript 编译器 API 将这些结构序列化为有效的 TypeScript 代码。

Guts 专注于最小的类型转换,提供变异来调整输出——例如,将 Go 类型转换为 TypeScript 枚举或类型别名。这种灵活性,加上它对 TypeScript 编译器的依赖,确保了语义上正确且最新的 TypeScript 定义。

Guts 旨在提供一个更动态和可配置的 Go 到 TypeScript 生成器替代方案。

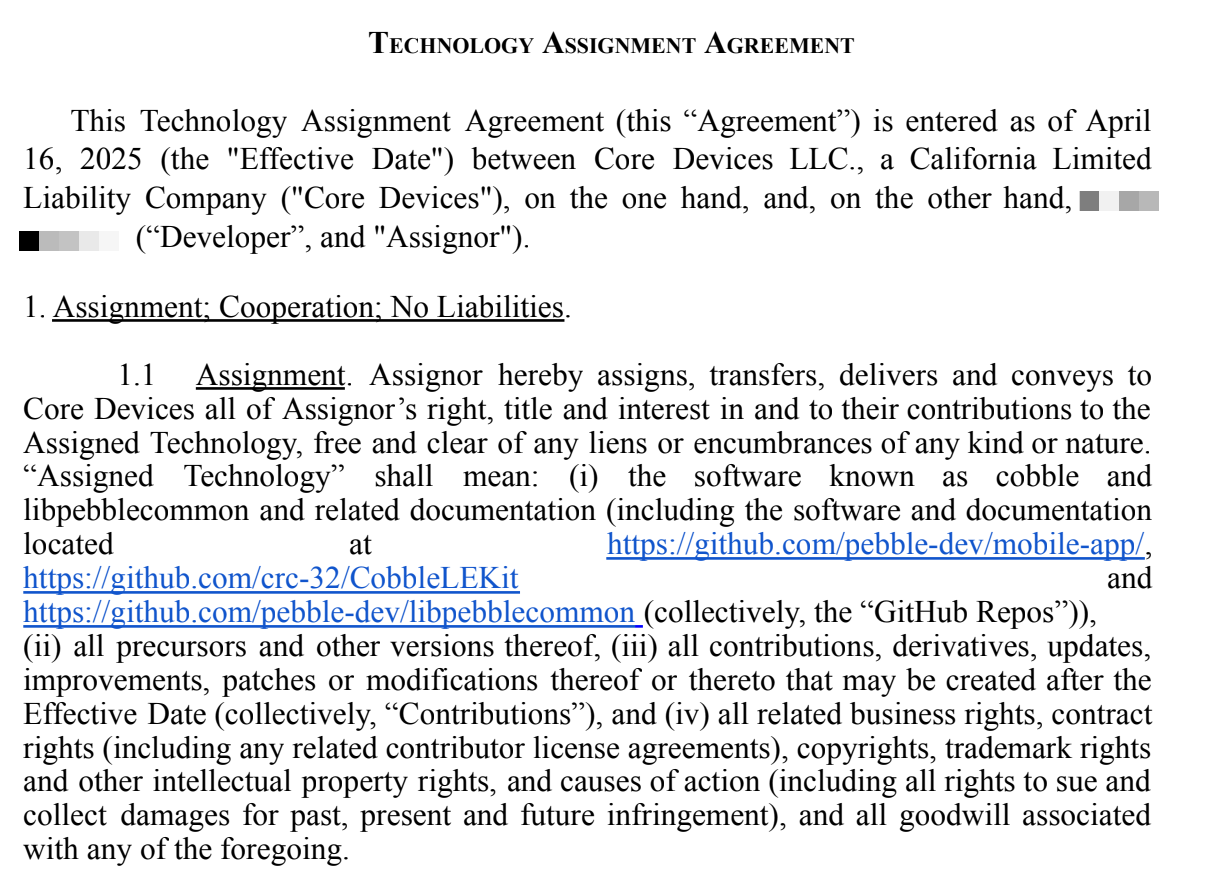

## Pebble 的未来:Core Devices 回应 Rebble 的说法

Core Devices(一家正在重新推出 Pebble 智能手表的公司)的创始人 Eric Migicovsky 回应了 Rebble(一个支持 Pebble 社区的非营利组织)提出的指控。这两个组织拥有共同的目标:保护 Pebble 的遗产。然而,双方在 Pebble 应用商店及其数据的未来发展上出现了分歧。

Core Devices 和 Rebble 最初同意 Core 每月向 Rebble 支付 0.20 美元/用户,以支持 Rebble 的服务。由于 Rebble 声称对最初上传到 Pebble 应用商店的 13,000 个应用程序和表盘拥有“100% 所有权”——这些数据是在 Fitbit 于 2018 年关闭应用商店后被 Rebble 抓取的数据——该协议破裂。Migicovsky 认为这些数据属于原始开发者,应该可以自由访问,并倡导一个开源档案。

Rebble 指责 Core Devices 利用 Rebble 资助的开源工作,并不正当地“抓取”应用商店。Migicovsky 反驳了这些说法,详细说明了独立开发,并澄清了他个人编录喜欢的表盘项目并非数据抓取。他强调自己对开源和 Pebble 可持续未来的承诺,与 Rebble 被认为想要控制形成对比。

Migicovsky 邀请 Rebble 发布应用商店数据的档案,并专注于社区利益,表达了他对 Pebble 长期生存的奉献精神,尽管存在冲突。

## Pebble 的未来:Core Devices 回应 Rebble 的说法

Core Devices(一家正在重新推出 Pebble 智能手表的公司)的创始人 Eric Migicovsky 回应了 Rebble(一个支持 Pebble 社区的非营利组织)提出的指控。这两个组织拥有共同的目标:保护 Pebble 的遗产。然而,双方在 Pebble 应用商店及其数据的未来发展上出现了分歧。

Core Devices 和 Rebble 最初同意 Core 每月向 Rebble 支付 0.20 美元/用户,以支持 Rebble 的服务。由于 Rebble 声称对最初上传到 Pebble 应用商店的 13,000 个应用程序和表盘拥有“100% 所有权”——这些数据是在 Fitbit 于 2018 年关闭应用商店后被 Rebble 抓取的数据——该协议破裂。Migicovsky 认为这些数据属于原始开发者,应该可以自由访问,并倡导一个开源档案。

Rebble 指责 Core Devices 利用 Rebble 资助的开源工作,并不正当地“抓取”应用商店。Migicovsky 反驳了这些说法,详细说明了独立开发,并澄清了他个人编录喜欢的表盘项目并非数据抓取。他强调自己对开源和 Pebble 可持续未来的承诺,与 Rebble 被认为想要控制形成对比。

Migicovsky 邀请 Rebble 发布应用商店数据的档案,并专注于社区利益,表达了他对 Pebble 长期生存的奉献精神,尽管存在冲突。

## 揭示科学文献中的隐藏知识

大量的潜在有价值知识仍然隐藏在不断扩大的科学研究体系中。这种“未被发现的公共知识”——埋藏在晦涩论文中、超前于时代或仅仅未被关联的发现——代表着巨大的创新机会。虽然丢失、专有或隐性知识是障碍,但许多有价值的见解*已经发表*但尚未关联。

由唐·斯旺森率先提出的文献为基础的发现(LBD)旨在揭示这些隐藏的联系,最初通过人工审查,现在越来越多地使用计算工具。早期方法侧重于术语的统计共现,发展到使用词嵌入和知识图谱等技术进行语义分析。这些图谱描绘了概念之间的关系,从而可以追踪复杂的推理路径。

尽管取得了进展,包括最近大型语言模型(LLM)的应用,LBD仍然面临挑战。评估成功仍然困难,而且LLM虽然强大,但可能会“产生幻觉”或缺乏人类科学家的变革性创造力。虽然LLM在辅助假设生成方面显示出前景,尤其是在药物再利用等领域(如COVID-19大流行期间所证明的),但实现LBD的全部潜力需要改进评估指标,解决语言固有的局限性,并促进LBD研究人员与领域专家之间的合作。最终,解锁这种“已知未知”可以通过将碎片化的知识组装成一个连贯的整体来加速科学进步。

## 揭示科学文献中的隐藏知识

大量的潜在有价值知识仍然隐藏在不断扩大的科学研究体系中。这种“未被发现的公共知识”——埋藏在晦涩论文中、超前于时代或仅仅未被关联的发现——代表着巨大的创新机会。虽然丢失、专有或隐性知识是障碍,但许多有价值的见解*已经发表*但尚未关联。

由唐·斯旺森率先提出的文献为基础的发现(LBD)旨在揭示这些隐藏的联系,最初通过人工审查,现在越来越多地使用计算工具。早期方法侧重于术语的统计共现,发展到使用词嵌入和知识图谱等技术进行语义分析。这些图谱描绘了概念之间的关系,从而可以追踪复杂的推理路径。

尽管取得了进展,包括最近大型语言模型(LLM)的应用,LBD仍然面临挑战。评估成功仍然困难,而且LLM虽然强大,但可能会“产生幻觉”或缺乏人类科学家的变革性创造力。虽然LLM在辅助假设生成方面显示出前景,尤其是在药物再利用等领域(如COVID-19大流行期间所证明的),但实现LBD的全部潜力需要改进评估指标,解决语言固有的局限性,并促进LBD研究人员与领域专家之间的合作。最终,解锁这种“已知未知”可以通过将碎片化的知识组装成一个连贯的整体来加速科学进步。

arXivLabs是一个框架,允许合作者直接在我们的网站上开发和分享新的arXiv功能。个人和与arXivLabs合作的组织都认同并接受了我们开放、社群、卓越和用户数据隐私的价值观。arXiv致力于这些价值观,并且只与秉持这些价值观的合作伙伴合作。您是否有为arXiv社群增加价值的项目想法?了解更多关于arXivLabs的信息。

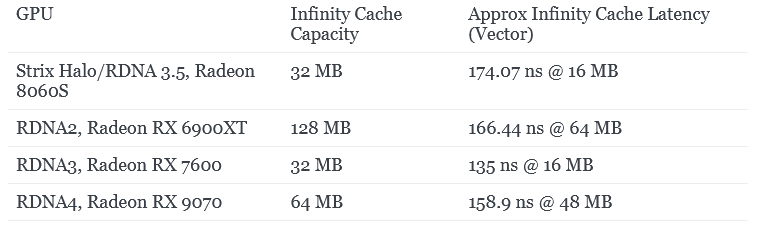

## AMD Strix Halo 内存子系统总结

AMD 的 Strix Halo 旨在在移动设备中提供强大的 CPU 和 GPU 性能,这给内存子系统带来了显著的挑战:平衡低延迟的 CPU 需求与高带宽的 GPU 需求,最大化容量,并保持低功耗。ROG Flow Z13 平板电脑展示了这种设计,配备 32GB 的 LPDDR5X 内存。

Strix Halo 使用 32MB 的 Infinity Cache (MALL) 作为 GPU 的最后一级缓存,类似于 RX 7600 等中低端独立显卡。虽然 Infinity Cache 的延迟略高于独立显卡,但对于移动设备来说,这是一个显著的容量提升。AMD 可以根据软件(前台/后台进程)动态调整 Infinity Cache 策略。值得注意的是,它绕过了主机侧内存分配。

CPU 方面,采用 16 个 Zen 5 核心通过 InFO_oS 封装连接,与台式机芯片相比,芯片间的带宽有所提升,但低于英特尔 Meteor Lake 或 AMD GMI-Wide 等设计。测试显示,跨 CCX 的延迟高于典型的台式机系统,这可能是由于优先考虑 GPU 带宽造成的。

最终,Strix Halo 优先考虑 GPU 性能,有时以牺牲 CPU 延迟为代价,尤其是在重负载下。鉴于其便携式游戏设备的 target 市场,这种权衡是合理的,在性能和外形尺寸之间取得了平衡。AMD 的设计展示了在移动电源限制下的出色带宽能力,为未来的 iGPU 发展铺平了道路。

## AMD Strix Halo 内存子系统总结

AMD 的 Strix Halo 旨在在移动设备中提供强大的 CPU 和 GPU 性能,这给内存子系统带来了显著的挑战:平衡低延迟的 CPU 需求与高带宽的 GPU 需求,最大化容量,并保持低功耗。ROG Flow Z13 平板电脑展示了这种设计,配备 32GB 的 LPDDR5X 内存。

Strix Halo 使用 32MB 的 Infinity Cache (MALL) 作为 GPU 的最后一级缓存,类似于 RX 7600 等中低端独立显卡。虽然 Infinity Cache 的延迟略高于独立显卡,但对于移动设备来说,这是一个显著的容量提升。AMD 可以根据软件(前台/后台进程)动态调整 Infinity Cache 策略。值得注意的是,它绕过了主机侧内存分配。

CPU 方面,采用 16 个 Zen 5 核心通过 InFO_oS 封装连接,与台式机芯片相比,芯片间的带宽有所提升,但低于英特尔 Meteor Lake 或 AMD GMI-Wide 等设计。测试显示,跨 CCX 的延迟高于典型的台式机系统,这可能是由于优先考虑 GPU 带宽造成的。

最终,Strix Halo 优先考虑 GPU 性能,有时以牺牲 CPU 延迟为代价,尤其是在重负载下。鉴于其便携式游戏设备的 target 市场,这种权衡是合理的,在性能和外形尺寸之间取得了平衡。AMD 的设计展示了在移动电源限制下的出色带宽能力,为未来的 iGPU 发展铺平了道路。

## 快速 LiteLLM:Rust 加速以提升性能

快速 LiteLLM 是 LiteLLM 框架的一个即插即用的 Rust 加速层,旨在通过**零配置**显著提升性能。它利用 PyO3 从 Rust 代码创建 Python 扩展,从而加速关键的 LiteLLM 函数,包括 token 计数(快 5-20 倍)、请求路由(快 3-8 倍)、速率限制(快 4-12 倍)和连接管理(快 2-5 倍)。

只需在 `litellm` 之前导入 `fast_litellm` 即可自动启用加速。该库具有强大的生产保障措施,例如功能标志、性能监控和自动回退到 Python。高级用户可以通过环境变量自定义行为,以实现逐步推广或禁用特定功能。

快速 LiteLLM 是线程安全的、类型安全的,并包含全面的测试以确保与现有 LiteLLM 功能的兼容性。提供预构建的 wheel,无需在安装过程中使用 Rust 工具链。欢迎贡献 – 项目的 GitHub 仓库中提供了详细的构建、测试和贡献指南。

## Gemini 3 Pro 现已在 Gemini CLI 中可用

Gemini 3 Pro,谷歌最智能的模型,现已集成到 Gemini CLI 中,为终端带来更强的性能和生产力。它解锁了命令的高级推理能力,改进了复杂工程任务的代理编码,并通过更好的工具使用实现更智能的工作流程。

访问权限正在向 Google AI Ultra 订阅者和拥有付费 Gemini API 密钥的用户开放。Gemini Code Assist Enterprise 用户很快也将获得访问权限,其他用户可以加入候补名单。

Gemini 3 Pro 在诸如根据详细提示生成完整的应用程序(例如,3D 金门大桥模拟)、将 UI 草图翻译成代码以及自动化复杂的调试和文档等工作流程方面表现出色。它甚至可以分析代码以生成用户文档或解决实时服务的性能问题。

最终,Gemini 3 Pro 旨在将命令行转变为一个智能伙伴,适应个人挑战并提高开发人员的效率。用户可以通过将 Gemini CLI 升级到 0.16.x 版本并使用 #GeminiCLI 分享他们的创作来开始探索其功能。

## Gemini 3 Pro 现已在 Gemini CLI 中可用

Gemini 3 Pro,谷歌最智能的模型,现已集成到 Gemini CLI 中,为终端带来更强的性能和生产力。它解锁了命令的高级推理能力,改进了复杂工程任务的代理编码,并通过更好的工具使用实现更智能的工作流程。

访问权限正在向 Google AI Ultra 订阅者和拥有付费 Gemini API 密钥的用户开放。Gemini Code Assist Enterprise 用户很快也将获得访问权限,其他用户可以加入候补名单。

Gemini 3 Pro 在诸如根据详细提示生成完整的应用程序(例如,3D 金门大桥模拟)、将 UI 草图翻译成代码以及自动化复杂的调试和文档等工作流程方面表现出色。它甚至可以分析代码以生成用户文档或解决实时服务的性能问题。

最终,Gemini 3 Pro 旨在将命令行转变为一个智能伙伴,适应个人挑战并提高开发人员的效率。用户可以通过将 Gemini CLI 升级到 0.16.x 版本并使用 #GeminiCLI 分享他们的创作来开始探索其功能。

谷歌搜索得益于Gemini 3的集成而得到显著提升。这次升级增强了搜索理解用户意图的能力,从而提供更全面、更相关的结果,并发现之前遗漏的内容。 很快,在AI模式和AI概览中具有挑战性的查询将自动路由到Gemini 3,以利用其卓越的推理能力,而较简单的任务将使用更快的模型。此推广首先面向美国Google AI Pro和Ultra订阅用户。 除了改进搜索结果外,Gemini 3还能够在AI模式中实现动态生成、定制化的用户界面。它分析问题以创建最佳的视觉布局——结合图像、表格,甚至实时编码的*交互式*工具和模拟,使信息更清晰、更具操作性。这超越了简单的文本回复,提供了真正量身定制且有用的体验。