## 人工智能的人力成本:工人敲响警钟 人工智能的承诺被构建它的人们的担忧所笼罩。在亚马逊Mechanical Turk等平台上工作的工人,负责评估和完善人工智能输出,越来越多地警告朋友和家人*不要*使用ChatGPT和Gemini等生成式人工智能工具。他们的亲身经历揭示了一个优先考虑速度和规模而非准确性和伦理的系统。 克里斯塔·帕洛斯基(Krista Pawloski)的一个关键时刻是在审核推文时,发现隐藏在看似无害的文本中的种族歧视用语——凸显了广泛且未被发现的偏见的可能性。这,加上观察同事不加批判地接受有缺陷的人工智能回复(甚至在医疗保健等敏感领域),导致许多评估员对这项技术失去信任。 这些工人报告了一种“垃圾进,垃圾出”的情况,即糟糕的训练数据导致不可靠的结果。他们对模糊的指示、有限的资源以及对报告问题的缺乏响应感到沮丧。专家认为,这表明存在系统性问题:激励措施偏向于快速部署而非仔细验证,并且往往忽略工人的反馈。 最终,这些“机器人观察者”强调人工智能是脆弱的,而不是未来的,并且依赖于庞大且常常看不见的人力。他们提倡批判性思维,质疑人工智能的输出,并要求对其开发和伦理影响保持透明。

每日HackerNews RSS

要使用 Mastodon 网页应用程序,请启用 JavaScript。或者,尝试为您的平台使用 Mastodon 的原生应用程序。

要使用 Mastodon 网页应用程序,请启用 JavaScript。或者,尝试为您的平台使用 Mastodon 的原生应用程序。

## Gitlogue:一款电影化的 Git 历史重放工具

Gitlogue 将你的 Git 提交历史转换为一个视觉上引人入胜、动画化的终端体验。它以逼真的打字动画、语法高亮(通过 Tree-sitter 支持 26 种语言)和动态文件树可视化来重放提交。

Gitlogue 使用 Rust 构建,以实现速度和效率,并提供自定义主题(9 个内置 + 完全自定义)、循环提交范围以及忽略特定文件的功能。它非常适合教育、演示、内容创作,或者仅仅为你的工作区添加一个动态显示——甚至可以作为“看起来很忙”模式!

**安装:** 可以通过脚本、Brew 或 Cargo 轻松安装。

**使用:** 使用命令控制特定提交、范围、顺序、速度和主题的播放。可以通过 `config.toml` 文件进行配置。

**注意:** Gitlogue 是一种视觉显示工具,*不是* 传统的屏幕保护程序,长时间在 OLED 显示器上使用可能会有烧屏风险。

据报道,苹果公司计划将重心从添加新功能转向提升软件*质量*,具体体现在iOS 27和macOS 27上。 继用户对“液态玻璃”等近期重新设计以及快速添加功能所导致的bug和性能问题提出抱怨后,苹果计划在WWDC26上发布一次“雪豹式”更新。

这意味着将集中精力消除臃肿、修复bug并提升所有平台上的整体性能。 虽然不会*完全*没有新功能,但重点将放在支持未来硬件(如可折叠iPhone)的基础改进上。

值得注意的是,苹果*将*集成新的AI功能,包括与潜在的Apple Health+订阅相关的AI健康助手,以及基于即将推出的AI增强Siri的AI驱动的网络搜索。 其他计划中的更新包括企业用户的增强功能、针对新兴市场的定制功能以及细微的设计调整。 这一举动对许多希望获得更稳定和完善的软件体验的苹果用户来说,是一个受欢迎的变化。

据报道,苹果公司计划将重心从添加新功能转向提升软件*质量*,具体体现在iOS 27和macOS 27上。 继用户对“液态玻璃”等近期重新设计以及快速添加功能所导致的bug和性能问题提出抱怨后,苹果计划在WWDC26上发布一次“雪豹式”更新。

这意味着将集中精力消除臃肿、修复bug并提升所有平台上的整体性能。 虽然不会*完全*没有新功能,但重点将放在支持未来硬件(如可折叠iPhone)的基础改进上。

值得注意的是,苹果*将*集成新的AI功能,包括与潜在的Apple Health+订阅相关的AI健康助手,以及基于即将推出的AI增强Siri的AI驱动的网络搜索。 其他计划中的更新包括企业用户的增强功能、针对新兴市场的定制功能以及细微的设计调整。 这一举动对许多希望获得更稳定和完善的软件体验的苹果用户来说,是一个受欢迎的变化。

更多证据表明人们正在寻找永久耐用的物品:这款Oceanus黄铜订书机获得了成功,它是由生产过20磅不锈钢饮水杯的公司带来的。这款无钉订书机由一英寸厚的黄铜块加工而成,使用冲孔穿透纸张,然后折叠一个标签以锁紧页面。“人体工程学设计,方便单手使用,Oceanus黄铜订书机平衡且使用起来非常令人满意,”该公司写道。这款小巧的订书机尺寸为2 ¾英寸见方,厚度为一英寸,但由于是黄铜材质,重量为13盎司。虽然没有那个杯子那么重,但肯定能用同样长的时间。这款售价90美元的订书机在Kickstarter上获得了巨大的成功;截至发稿时,已筹集到16万美元,还有26天可以进行认购。

更多证据表明人们正在寻找永久耐用的物品:这款Oceanus黄铜订书机获得了成功,它是由生产过20磅不锈钢饮水杯的公司带来的。这款无钉订书机由一英寸厚的黄铜块加工而成,使用冲孔穿透纸张,然后折叠一个标签以锁紧页面。“人体工程学设计,方便单手使用,Oceanus黄铜订书机平衡且使用起来非常令人满意,”该公司写道。这款小巧的订书机尺寸为2 ¾英寸见方,厚度为一英寸,但由于是黄铜材质,重量为13盎司。虽然没有那个杯子那么重,但肯定能用同样长的时间。这款售价90美元的订书机在Kickstarter上获得了巨大的成功;截至发稿时,已筹集到16万美元,还有26天可以进行认购。

泄露的电子邮件显示,硅谷精英与以色列政治人物之间存在长期而密切的联系,可追溯到至少2014年。臭名昭著的金融家杰弗里·爱泼斯坦积极试图将彼得·蒂尔等科技巨头与前以色列总理埃胡德·巴拉克联系起来,而罗恩·普罗索等官员则积极寻求与蒂尔和帕兰蒂尔的关系,甚至寻找就业机会。 这些邮件往来涵盖2000年至2018年,凸显了一种“国防科技外交”旋转门现象,巴拉克、普罗索和贝尼·甘茨等人物寻求进入帕兰蒂尔、甲骨文和亚马逊等公司。帕兰蒂尔尤其受到关注,以色列官员认识到其潜力并积极招募其人员。 除了建立人脉,邮件还显示了在硅谷培养亲以色列情绪的尝试,包括真人秀的策划以及讨论如何对抗BDS运动。在10月7日袭击事件发生后,这种关系进一步加深,帕兰蒂尔公开支持以色列,并与以色列国防部建立了战略合作伙伴关系。这些交流表明,个人关系和战略利益如何交织在一起,模糊了科技和地缘政治领域中国家服务与私人利益之间的界限。

佐林 (Zorin)

佐林操作系统 (Zorin OS)

佐林网格 (Zorin Grid)

电脑

帮助

☰ 菜单

佐林博客

订阅我们的新闻邮件

页面未找到。

请检查网址是否有拼写错误,或返回博客。

前往博客

插图:Marina Fedoseenko

佐林操作系统主页

获取关于佐林和技巧的最新消息到您的收件箱。

订阅我们的新闻邮件

爱尔兰制造 ☘️

产品

佐林操作系统 (Zorin OS)

佐林网格 (Zorin Grid)

电脑

帮助

如何安装佐林操作系统

系统要求

切换您的组织

其他帮助文章

公司

关于

博客

新闻稿

捐赠

© 2008 - 2025 佐林集团 版权所有。本网站使用的任何商标或徽标均为其各自所有者的财产。

服务条款隐私政策Cookie政策

佐林 (Zorin)

佐林操作系统 (Zorin OS)

佐林网格 (Zorin Grid)

电脑

帮助

☰ 菜单

佐林博客

订阅我们的新闻邮件

页面未找到。

请检查网址是否有拼写错误,或返回博客。

前往博客

插图:Marina Fedoseenko

佐林操作系统主页

获取关于佐林和技巧的最新消息到您的收件箱。

订阅我们的新闻邮件

爱尔兰制造 ☘️

产品

佐林操作系统 (Zorin OS)

佐林网格 (Zorin Grid)

电脑

帮助

如何安装佐林操作系统

系统要求

切换您的组织

其他帮助文章

公司

关于

博客

新闻稿

捐赠

© 2008 - 2025 佐林集团 版权所有。本网站使用的任何商标或徽标均为其各自所有者的财产。

服务条款隐私政策Cookie政策

## 工程管理中的动态变化

对工程管理者的期望在不断演变,这种变化并非源于根本的道德转变,而是由不断变化的商业现实驱动。十年前被认为是“优秀领导力”的做法——在高速增长时期赋能工程师——如今常常被认为是官僚主义和效率低下的,尤其是在今天这个注重成本和人工智能的环境中。这种循环不断重复,让管理者感觉始终在追赶。

与其追逐短暂的领导潮流,长期成功的关键在于培养**八项基础技能**:**执行力**、**团队建设**、**责任心**、**协同一致**(核心技能),以及**品味**、**清晰度**、**驾驭模糊性**和**跨越时间尺度工作**(成长技能)。

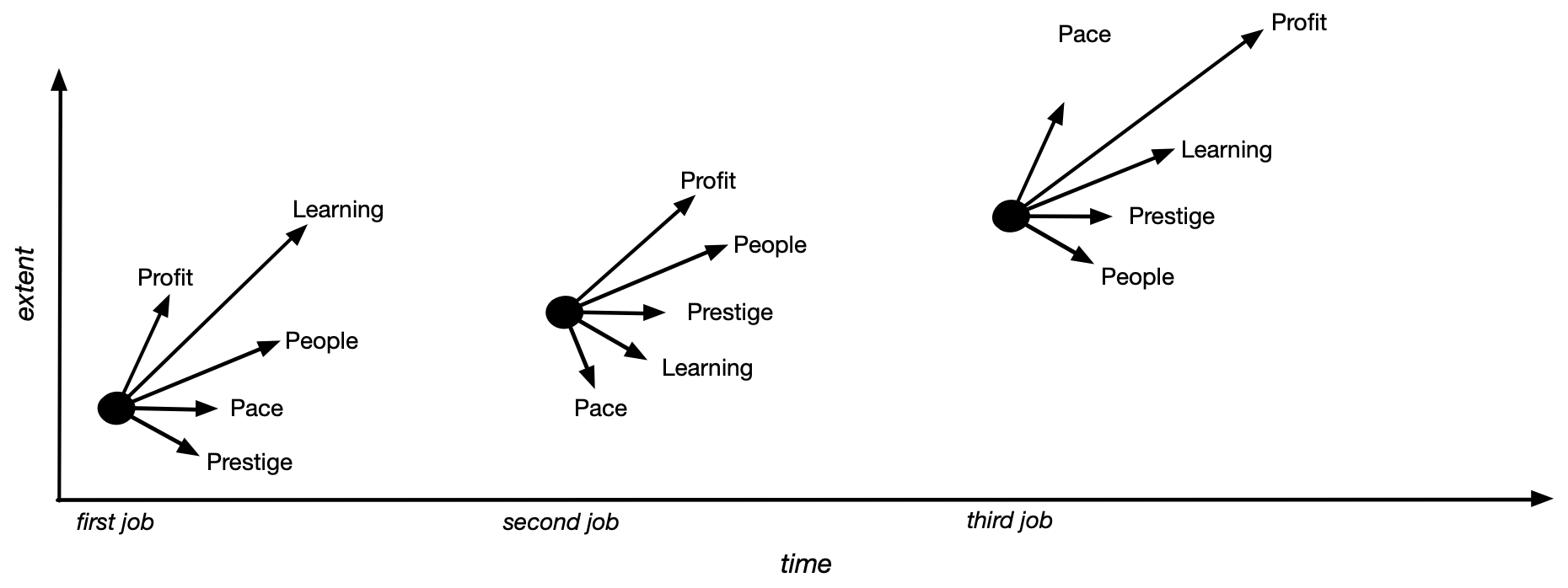

对照这些技能进行自我评估至关重要。除了技能发展之外,保持积极性也很重要——在最大化影响力的同时,优先处理能让你充满*活力*的工作。成功的四十年的职业生涯需要深思熟虑的选择,承认节奏、人员、声望和学习之间的权衡,并理解这些选择如何随着时间推移而产生复利效应。最终,认识到“优秀领导力”只是一种潮流,才能专注于培养持久的技能,并拥有可持续且充实的职业生涯。

## 工程管理中的动态变化

对工程管理者的期望在不断演变,这种变化并非源于根本的道德转变,而是由不断变化的商业现实驱动。十年前被认为是“优秀领导力”的做法——在高速增长时期赋能工程师——如今常常被认为是官僚主义和效率低下的,尤其是在今天这个注重成本和人工智能的环境中。这种循环不断重复,让管理者感觉始终在追赶。

与其追逐短暂的领导潮流,长期成功的关键在于培养**八项基础技能**:**执行力**、**团队建设**、**责任心**、**协同一致**(核心技能),以及**品味**、**清晰度**、**驾驭模糊性**和**跨越时间尺度工作**(成长技能)。

对照这些技能进行自我评估至关重要。除了技能发展之外,保持积极性也很重要——在最大化影响力的同时,优先处理能让你充满*活力*的工作。成功的四十年的职业生涯需要深思熟虑的选择,承认节奏、人员、声望和学习之间的权衡,并理解这些选择如何随着时间推移而产生复利效应。最终,认识到“优秀领导力”只是一种潮流,才能专注于培养持久的技能,并拥有可持续且充实的职业生涯。

## 人工智能成本上升:更多Token,价格趋于平稳 近期趋势显示,人工智能推理经济正在发生转变。虽然Token成本正在稳定,但*Token消耗量*却在迅速增加——这不仅仅是由于用户数量增加,而是因为应用程序为了获得更高质量的结果,正在使用*每个请求更多的Token*。 这受到更丰富上下文的需求驱动,通常通过使用LLM来预处理和评估数据来实现(例如,重新排序搜索结果)——这种做法越来越普遍。 需求的增加正在给基础设施带来压力,但成本降低的速度跟不上。为了管理不断上涨的费用,应用程序开发者应优先考虑:为每个任务使用适当大小的模型,多样化模型提供商,仔细评估对昂贵“推理”模型的需求,以及谨慎对待微调,这需要大量高质量的数据。 最终,重点应该从单纯降低成本转向最大化价值。随着人工智能应用程序的成熟并证明明确的投资回报率,可能会出现提高定价能力的机会,特别是对于那些提供卓越质量的应用。 尽管持续努力提高效率,但随着Token使用量的增加,预计将继续密切关注人工智能账单。