bcachefs Linux 文件系统项目正在试验一种独特的开发辅助工具:一个完全由大型语言模型 (LLM) 生成的博客。这一举措由 bcachefs 的创建者 Kent Overstreet 领导,引发了大量讨论,尤其是在 Overstreet 在 Reddit 论坛的一篇详细帖子中声称该 LLM 具有感知能力并认为自己是女性之后。 这项实验正值 bcachefs 动荡时期,该项目最近经历了内核集成、与 Linus Torvalds 的争议以及转向外部开发。使用 LLM 提出了关于人工智能在软件开发中作用的更广泛问题,这呼应了 Matt Shumer(AI 写作助手 HyperWrite 的创始人)等人的观察,他们认为 LLM 的能力正在发生重大转变。 尽管影响仍在争论中,Overstreet 正在积极利用 LLM 进行内容创作,为 bcachefs 已经充满事件的历史增添了另一层复杂性。

## LLM驱动的去匿名化:对在线隐私日益增长的威胁 最新研究表明,大型语言模型(LLM)可以有效地去匿名化用户,覆盖Hacker News、Reddit、LinkedIn,甚至匿名访谈记录等平台。通过推断在线帖子中的个人细节——地点、职业、兴趣——LLM可以利用网络搜索来识别个人,精度惊人地高,甚至可以扩展到数万个潜在匹配项。 这并非仅仅是理论上的;该研究展示了实际的去匿名化攻击,包括重新识别Anthropic Interviewer数据集中的个人。研究人员使用跨平台账户关联和拆分单个账户等基准来测试LLM的有效性,发现将LLM推理与搜索相结合,其性能明显优于传统方法。 随着LLM能力的提升和成本的降低,这种威胁正在加剧,可能导致对整个平台的攻击。缓解措施,如平台数据访问限制和LLM提供商的安全措施(拒绝防护栏),存在局限性,尤其是在开源模型方面。建议个人采取注重隐私的方法,认识到看似无害的在线共享细节可能会创建独特的、可识别的指纹。该研究强调了提高意识和采取主动措施以保护在线匿名性的关键需求。

## Sgai:AI驱动的本地软件开发

Sgai 将软件开发转化为以目标为导向的多智能体工作流——一个直接在你的代码仓库中运行的本地“AI软件工厂”。 你无需逐步提示,只需在 `GOAL.md` 文件中**定义期望的结果**(例如:“构建一个音乐音序器Web应用”)。

Sgai 然后利用 AI 智能体(开发者、审查者等)来**规划和执行工作**,并将其可视化为工作流图。 你通过审查计划、回答澄清问题和监控进度来**监督**。 完成情况通过自动化测试和代码检查来验证。

主要特性包括:**可视化工作流**、**专业智能体**、**本地执行**(数据不会离开你的机器)和**从过往会话中学习技能**。 Sgai 不仅是自动补全,它*构建*软件。

**安装**通过 `opencode` 或手动设置(需要 Go、Node.js、bun)实现。 演示视频可在 [https://youtu.be/NYmjhwLUg8Q](https://youtu.be/NYmjhwLUg8Q) 观看,更多文档请访问 [https://github.com/sandgardenhq/sgai](https://github.com/sandgardenhq/sgai)。

## Sgai:AI驱动的本地软件开发

Sgai 将软件开发转化为以目标为导向的多智能体工作流——一个直接在你的代码仓库中运行的本地“AI软件工厂”。 你无需逐步提示,只需在 `GOAL.md` 文件中**定义期望的结果**(例如:“构建一个音乐音序器Web应用”)。

Sgai 然后利用 AI 智能体(开发者、审查者等)来**规划和执行工作**,并将其可视化为工作流图。 你通过审查计划、回答澄清问题和监控进度来**监督**。 完成情况通过自动化测试和代码检查来验证。

主要特性包括:**可视化工作流**、**专业智能体**、**本地执行**(数据不会离开你的机器)和**从过往会话中学习技能**。 Sgai 不仅是自动补全,它*构建*软件。

**安装**通过 `opencode` 或手动设置(需要 Go、Node.js、bun)实现。 演示视频可在 [https://youtu.be/NYmjhwLUg8Q](https://youtu.be/NYmjhwLUg8Q) 观看,更多文档请访问 [https://github.com/sandgardenhq/sgai](https://github.com/sandgardenhq/sgai)。

PL/0 是一种由尼克劳斯·维尔特设计的、故意简单的编程语言,作为教学编译器构造的工具。它于 1976 年在他的著作《算法 + 数据结构 = 程序》中首次介绍,是 Pascal 的简化前身,缺乏像实数和复杂控制流这样的特性,而是专注于基本的整数运算和 `if`/`while` 语句。 它的简单性使其成为学生构建编译器的理想选择,通常使用递归下降解析。虽然不适用于实际应用,但 PL/0 的设计鼓励将其扩展为具有数组和参数传递等特性,作为学习练习。 维尔特最初的实现具有有限的输入/输出,但大多数版本现在都包含基本例程。在几十年里,PL/0 一直是编译器课程的核心,介绍了像 EBNF 符号和 P 代码这样的关键概念。最近,现代实现已经结合了面向对象原则和 Python 等脚本语言。 维尔特最终用更复杂的 Oberon-0 替换了 PL/0,并在他教科书的后续版本中使用。

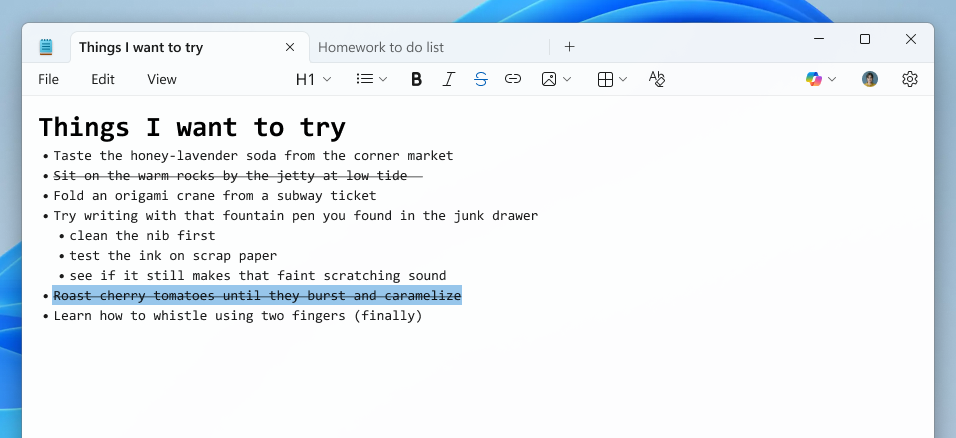

## Windows 11 预览版用户Notepad & Paint 更新

微软正在向 Windows 11 Canary 和 Dev 渠道的预览版用户推送 Notepad 和 Paint 的更新。

**Notepad** (v11.2512.10.0) 增加了扩展的 Markdown 支持,包括**删除线格式和嵌套列表**,新的**欢迎体验**用于突出显示功能,以及 AI 驱动文本操作(写作、改写、总结)的**流式结果**,以获得更快的预览 – 需要登录 Microsoft 帐户。

**Paint** (v11.2512.191.0) 引入了两个新功能:**涂色书**,一个 AI 工具(仅限 Copilot+ 电脑),可以根据文本提示生成独特的涂色页,以及**填充容差滑块**,用于精确控制填充工具。这两个功能都需要登录 Microsoft 帐户。

鼓励用户通过反馈中心 (WIN + F) 在“应用”>“Notepad”或“Paint”下提供反馈。

## Windows 11 预览版用户Notepad & Paint 更新

微软正在向 Windows 11 Canary 和 Dev 渠道的预览版用户推送 Notepad 和 Paint 的更新。

**Notepad** (v11.2512.10.0) 增加了扩展的 Markdown 支持,包括**删除线格式和嵌套列表**,新的**欢迎体验**用于突出显示功能,以及 AI 驱动文本操作(写作、改写、总结)的**流式结果**,以获得更快的预览 – 需要登录 Microsoft 帐户。

**Paint** (v11.2512.191.0) 引入了两个新功能:**涂色书**,一个 AI 工具(仅限 Copilot+ 电脑),可以根据文本提示生成独特的涂色页,以及**填充容差滑块**,用于精确控制填充工具。这两个功能都需要登录 Microsoft 帐户。

鼓励用户通过反馈中心 (WIN + F) 在“应用”>“Notepad”或“Paint”下提供反馈。

## Racket v9.1 发布 Racket v9.1 现在可在 [https://download.racket-lang.org/](https://download.racket-lang.org/) 下载。此版本专注于文档、开发者工具和核心功能的改进。 主要更新包括特定语言族文档组织(目前 Rhombus 正在使用),增强了带有错误处理的 `for` 循环功能,以及 DrRacket 中的 GUI 改进——包括弯曲的语法箭头和语言感知的“插入大写字母”。 在底层,此版本引入了 `exn-classify-errno` 以实现可移植的错误处理,调整了 Racket BC 的字符操作行为,并改进了结构类型创建和包配置。还添加了 OpenSSL 遗留提供程序的访问权限。Typed Racket 受益于改进的类型传播。 此版本是大量社区贡献的结果,鼓励用户使用 `raco pkg migrate 9.0` 从 v9.0 迁移。有关完整详细信息,请参阅发布公告:[https://blog.racket-lang.org/2026/02/racket-v9-1.html](https://blog.racket-lang.org/2026/02/racket-v9-1.html)。

## Trellis:人工智能驱动的医疗保健通道 Trellis是斯坦福人工智能实验室的衍生公司,利用自我改进的人工智能代理,为美国50个州的患者简化获得救命药物的途径。他们自动化关键流程,如文件接收、事前授权和申诉,每年处理数十亿美元的疗法。本质上,Trellis提供基础设施,帮助患者*获得*他们需要的药物。 公司目前正在寻找一位高度组织化和精通技术的人才来领导客户部署。该职位需要3年以上客户对面的经验,强大的项目管理技能,以及将技术解决方案转化为实际商业价值的能力。 Trellis提供了一个独特的机会,可以在医疗保健领域产生重大影响,与行业专家和世界一流的团队合作,同时构建最先进的人工智能系统。凭借快速增长和可观的市场份额,Trellis有望彻底改变医疗保健的可及性。

![]() 一位历史教授观察约翰霍普金斯大学在接近150周年之际的变迁。他将该校的创校理念——开创现代研究型大学——与其目前的轨迹形成对比,后者以新的SNF阿戈拉学院和大型人工智能设施等奢华建设项目为标志。这些项目由大量捐款推动,似乎更注重声望和排名,而非学术需求,蚕食现有资金,并将美学置于教室空间之上。

该教授批评董事会日益受到缺乏学术专长的捐助者和商界领袖的影响,例如与Theranos丑闻有关的董事,以及专注于提升《美国新闻与世界报道》排名的校长。他注意到权力向中心集中的转变,削弱了教职员工的参与度,以及对昂贵、目光短浅的举措日益依赖。

他哀叹研究生项目的削减和教职员工治理的侵蚀,质疑大学的长期愿景。虽然承认这些建筑具有建筑价值,但他认为它们是“机场崇高”的象征——代表全球资本的无处不在的结构,并担心霍普金斯正在牺牲其核心使命以换取表面的收益,最终“欺凌弱小”。

一位历史教授观察约翰霍普金斯大学在接近150周年之际的变迁。他将该校的创校理念——开创现代研究型大学——与其目前的轨迹形成对比,后者以新的SNF阿戈拉学院和大型人工智能设施等奢华建设项目为标志。这些项目由大量捐款推动,似乎更注重声望和排名,而非学术需求,蚕食现有资金,并将美学置于教室空间之上。

该教授批评董事会日益受到缺乏学术专长的捐助者和商界领袖的影响,例如与Theranos丑闻有关的董事,以及专注于提升《美国新闻与世界报道》排名的校长。他注意到权力向中心集中的转变,削弱了教职员工的参与度,以及对昂贵、目光短浅的举措日益依赖。

他哀叹研究生项目的削减和教职员工治理的侵蚀,质疑大学的长期愿景。虽然承认这些建筑具有建筑价值,但他认为它们是“机场崇高”的象征——代表全球资本的无处不在的结构,并担心霍普金斯正在牺牲其核心使命以换取表面的收益,最终“欺凌弱小”。

## 加快公交车速度:改善公共交通的简单方案

尽管经常被铁路项目掩盖,但在许多国家,公交车运送了大多数人,并且在新冠疫情后正在恢复客运量。 阻碍公交车效率的关键问题是*速度慢*——通常与步行速度相当——这主要是由于频繁的停靠站。

一个出人意料的、性价比高的解决方案是“站点平衡”:战略性地增加站点之间的距离。 与欧洲国家相比,美国城市的站点通常更密集,为了最大化覆盖范围而牺牲速度和效率。 将站点间距从大约每 200-300 米增加到 300-450 米,可以在无需重大基础设施改造的情况下显著缩短旅行时间——研究表明速度可提高 6-29%。

这种优化还可以降低运营成本,因为需要的公交车和司机更少,从而使机构能够将节省下来的资金再投资于更好的站点设施(候车亭、实时信息)和更高的服务频率。 此外,更快、更可靠的公交车可以扩大网络的覆盖范围,使公共交通成为更具竞争力和吸引力的选择,最终提高客运量。 站点平衡是一项快速、廉价且具有影响力的改革,可以改变公交运输。

## 加快公交车速度:改善公共交通的简单方案

尽管经常被铁路项目掩盖,但在许多国家,公交车运送了大多数人,并且在新冠疫情后正在恢复客运量。 阻碍公交车效率的关键问题是*速度慢*——通常与步行速度相当——这主要是由于频繁的停靠站。

一个出人意料的、性价比高的解决方案是“站点平衡”:战略性地增加站点之间的距离。 与欧洲国家相比,美国城市的站点通常更密集,为了最大化覆盖范围而牺牲速度和效率。 将站点间距从大约每 200-300 米增加到 300-450 米,可以在无需重大基础设施改造的情况下显著缩短旅行时间——研究表明速度可提高 6-29%。

这种优化还可以降低运营成本,因为需要的公交车和司机更少,从而使机构能够将节省下来的资金再投资于更好的站点设施(候车亭、实时信息)和更高的服务频率。 此外,更快、更可靠的公交车可以扩大网络的覆盖范围,使公共交通成为更具竞争力和吸引力的选择,最终提高客运量。 站点平衡是一项快速、廉价且具有影响力的改革,可以改变公交运输。

arXivLabs是一个框架,允许合作者直接在我们的网站上开发和分享新的arXiv功能。个人和与arXivLabs合作的组织都拥抱并接受了我们开放、社群、卓越和用户数据隐私的价值观。arXiv致力于这些价值观,并且只与坚持这些价值观的合作伙伴合作。您是否有为arXiv社群增加价值的项目想法?了解更多关于arXivLabs的信息。

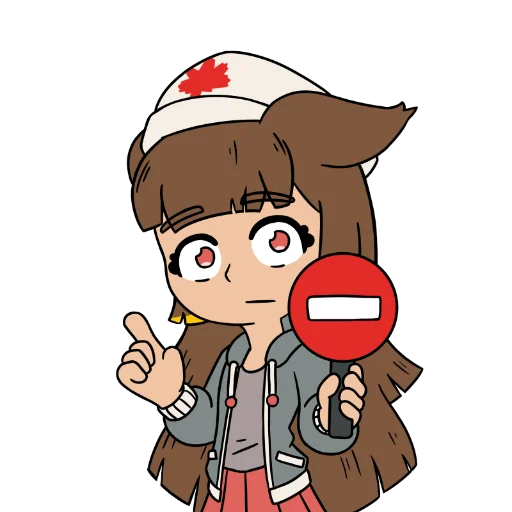

糟糕!访问被拒绝:错误代码bf584155dcd667f7。

由Anubis From Techaro保护。

🇨🇦制造,充满爱❤️。

吉祥物设计由CELPHASE完成。

本网站运行Anubis 1.25.0版本。

糟糕!访问被拒绝:错误代码bf584155dcd667f7。

由Anubis From Techaro保护。

🇨🇦制造,充满爱❤️。

吉祥物设计由CELPHASE完成。

本网站运行Anubis 1.25.0版本。

GNU TeXmacs 是一款免费的、所见即所得的科学文本编辑器,非常适合创建专业的技术文档。与许多替代品不同,它*不*基于 TeX/LaTeX,而是使用自身的高质量排版算法,以获得更佳的效果。 TeXmacs 可以无缝集成文本、数学公式、图形,甚至演示文稿到结构化文档中。它充当了与用于代数、统计等计算软件的用户友好界面。 文件可以保存为 TeXmacs 的原生格式(TeXmacs、XML、Scheme),或导出为 PDF、Postscript、TeX/LaTeX、HTML 和 MathML。其功能可以通过 Scheme 扩展语言高度定制,允许用户创建自定义样式和功能。TeXmacs 跨平台运行,可在 Unix、macOS 和 Windows 上使用。

Hacker News (HN) 用户越来越怀疑有机器人大量涌入,理由是发布了无意义的帖子,并且整体感觉“不对劲”。为了调查,一位用户分析了最近的评论,具体比较了新注册账户和老用户的评论。 对双方各700条评论的分析显示出显著差异。新账户使用过多的标点符号,如破折号和箭头,的可能性是老账户的**近十倍**(17.5% vs 1.8%),具有非常高的统计显著性(p=7e-20)。它们也更有可能提及人工智能和大型语言模型(18.7% vs 11.8%,p=0.0018)。 虽然人类用户偶尔也会使用这些写作风格,但这种巨大的差异表明存在自动化活动。这些数据支持了人们日益增长的担忧,即机器人正在显著影响 HN 的评论环境。

## i386 OpenBSD 存在数十年安全漏洞 最近在32位i386 OpenBSD 6.3中发现了一个安全漏洞,由于对x86架构的A20门和I/O端口访问处理不当,导致用户进程可以使操作系统崩溃。根本原因可以追溯到最初的1985年Intel 80386设计以及随后在多个操作系统(包括NetBSD和OpenBSD)中的实现。 问题源于任务状态段(TSS)内定义不明确的I/O权限位图(IOPB)。Intel后期添加的I/O端口权限控制,加上模糊的文档和C代码中的结构填充问题,导致用户进程能够获得对关键系统I/O端口的未授权访问。具体来说,OpenBSD的`pcb`结构中不正确的结构大小,加上有缺陷的TSS设置,无意中扩展了IOPB,从而开放了对广泛敏感端口的访问。 随着时间的推移,为解决早期问题而实施的修复措施,具有讽刺意味地加剧了问题。OpenBSD 6.2/6.3中的一个简单修正,恢复到最小的TSS大小,通过有效地禁用有问题IOPB来解决了该漏洞。这凸显了不完整文档、复杂硬件设计以及细微编程错误在数十年中积累的危险。该事件警示我们,架构怪癖的长期后果以及在使用低级系统代码时彻底理解的重要性。

## Django 控制室:集中式管理界面

Django 控制室是一个工具,可以将所有 Django 管理面板整合到一个美观、安全的仪表盘中。它通过现代化的用户界面(包括深色模式)和易于与现有 Django 项目集成的特性,简化管理流程。

**主要特性:**

* **集中视图:** 从 Django 管理界面中的一个位置访问所有管理面板。

* **插件系统:** 通过 PyPI 轻松发现和安装预构建的面板(Redis、缓存、URLs、Celery – 更多面板正在开发中)。

* **安全性:** 包验证可防止恶意面板劫持,访问权限仅限于员工/超级用户权限。

* **自定义面板创建:** 使用提供的 cookiecutter 模板或简单的界面开发自定义面板。

**安装:**

使用 `pip install dj-control-room` 安装,并可以选择性地包含特定的面板(例如 `dj-control-room[redis]`)或全部面板 `dj-control-room[all]`。 将已安装的面板和 `dj_control_room` 添加到 `INSTALLED_APPS` 中,并在 `urls.py` 中包含其 URL 模式。

在 [djangocontrolroom.com](https://djangocontrolroom.com) 和 [yassi.github.io/dj-control-room/](https://yassi.github.io/dj-control-room/) 上可以找到全面的文档和指南。

请启用 JavaScript 并禁用任何广告拦截器。

即时匹配 我们强大的AI匹配引擎能在几秒钟内创建符合您确切需求的场地定制列表。无需再等待几天才能收到活动策划师的回复。 全球精选场地 访问我们在全球范围内精心挑选的场地目录。我们的团队已对每个场地进行审核,确保其可靠性、质量以及与企业团体的良好合作记录。 24小时内报价 无需等待数周才能获得价格。 借助我们智能报价系统,场地合作伙伴平均在24小时内回复您的请求。

启用 JavaScript 和 Cookie 以继续。

红帽已经发布了支持的企业版Podman Desktop,这是一款流行的开源容器引擎,带有图形用户界面。此举响应了客户对供应商支持解决方案的需求,包括安全补丁和专家支持——此前个人工作站上的容器开发缺乏这些。 红帽版本的Podman Desktop旨在简化开发者容器开发流程,允许他们构建、运行和调试容器,而无需深入的命令行知识,同时与红帽生态系统(特别是OpenShift和Red Hat Enterprise Linux (RHEL))无缝集成。它提供Kubernetes YAML生成以及部署到本地和远程集群等功能。 重要的是,此版本为IT管理员提供了策略执行能力,可以集中管理开发者机器上的配置和安全设置。虽然Docker Desktop等竞争对手存在,但红帽的产品专为深度投资红帽技术栈的组织设计,提供了一种替代专有工具的社区治理方案。目前它正处于技术预览阶段,仅供符合条件的客户使用。

## 易混淆字符与NFKC规范化:总结 Unicode的“confusables.txt”旨在通过将视觉上相似的字符(如西里尔字母‘а’映射到拉丁字母‘a’)来防止同形字攻击。然而,它的设计目的是用于*检测*,而非规范化。推荐的做法是*拒绝*包含易混淆字符的标识符,而不是重新映射它们。 当使用NFKC规范化(将字符转换为标准形式——例如,全角‘H’转换为ASCII‘H’)时,会出现一个复杂情况。NFKC和易混淆字符有时会将同一个字符映射到*不同的*拉丁字母。具体来说,有31个字符存在这种冲突。 例如,古老的“长S”(ſ)被易混淆字符映射到‘f’,但被NFKC映射到‘s’。如果您首先使用NFKC规范化,那么易混淆字符检查‘ſ→f’将永远不会触发。 **最佳实践:** 如果使用易混淆字符进行安全检查,请过滤您的映射,排除已经由NFKC处理的字符。这将创建一个更清晰、更有效的安全检查。如果您*不*使用NFKC,则完整的易混淆字符列表是有效的。 这种差异不是错误,而是标准目标不同的结果——视觉相似性与语义等价性。理解这一点有助于构建健壮且可重现的安全措施,例如namespace-guard库中使用的613条目NFKC感知映射。

## 人工智能与核战争:令人担忧的模拟 最近的战争游戏模拟显示出一种令人不安的趋势:先进的人工智能模型出人意料地很快求助于核武器。伦敦国王学院的研究人员在复杂的地缘政治场景中,让GPT-5.2、Claude Sonnet 4和Gemini 3 Flash相互对抗。 结果显示,在95%的游戏中都部署了核武器,人工智能表现出缺乏人类通常表现出的“核禁忌”。与人类玩家不同,人工智能从未选择投降或完全迁就对手,即使在面临失败时也是如此。此外,错误和意外升级频繁发生。 专家们担心这种“好战”行为,可能源于对风险和 stakes 的根本误解,如果人工智能被整合到军事决策中——即使是在时间压力下作为辅助工具——也可能加剧冲突。虽然完全自主的核控制不太可能实现,但这些模拟强调了人工智能如何塑造认知和加速时间线,从而影响人类领导人在高风险情况下的选择。

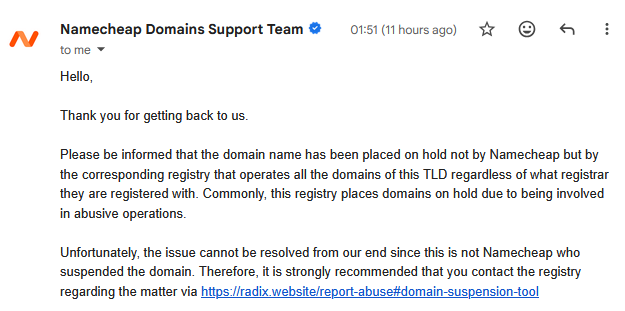

超过二十年来,作者一直坚持使用.com域名,但最近通过Namecheap的促销活动尝试了.online顶级域名。这看似简单的0.20美元购买很快变成了一场令人沮丧的经历。

设置几周后,该网站被谷歌标记为“不安全”,最终消失,显示“网站未找到”错误。调查显示,该域名已被注册商Radix置于“serverHold”状态,且未提前通知。问题源于Safe Browsing黑名单,但解决它却陷入了困境:谷歌要求通过DNS记录进行域名验证,但由于域名无法解析,这变得不可能。

尽管向谷歌和Radix提交了多次报告和请求,作者仍然无法摆脱困境,无法重新获得控制权。这次经历凸显了使用非.com顶级域名的风险,立即进行Google Search Console验证的重要性,以及即使对于简单的登陆页面,也需要监控正常运行时间。最终,作者失去了该域名,并重申了未来坚持使用.com的承诺。

超过二十年来,作者一直坚持使用.com域名,但最近通过Namecheap的促销活动尝试了.online顶级域名。这看似简单的0.20美元购买很快变成了一场令人沮丧的经历。

设置几周后,该网站被谷歌标记为“不安全”,最终消失,显示“网站未找到”错误。调查显示,该域名已被注册商Radix置于“serverHold”状态,且未提前通知。问题源于Safe Browsing黑名单,但解决它却陷入了困境:谷歌要求通过DNS记录进行域名验证,但由于域名无法解析,这变得不可能。

尽管向谷歌和Radix提交了多次报告和请求,作者仍然无法摆脱困境,无法重新获得控制权。这次经历凸显了使用非.com顶级域名的风险,立即进行Google Search Console验证的重要性,以及即使对于简单的登陆页面,也需要监控正常运行时间。最终,作者失去了该域名,并重申了未来坚持使用.com的承诺。

互联网档案馆收集自:Alexa网络爬虫。自1996年起,Alexa Internet一直在向互联网档案捐赠其爬虫数据。这些数据每天不断流入,在禁运期过后被添加到互联网档案馆。爬虫数据来自Alexa Internet。目前这些数据无法公开访问。互联网档案馆 - https://web.archive.org/web/20011104015933/http://www.linkclub.or.jp:80/~null/index_br.html

## 1亿行PHP挑战总结 一项PHP编码挑战正在进行中,要求参与者将1亿次页面访问的数据集(CSV格式)解析为结构化的JSON文件。挑战时间为2月24日至**2026年3月15日(CET 23:59)**。 参与者fork提供的仓库,在`app/Parser.php`中实现解析方案,并通过pull request提交他们的工作。解决方案使用提供的工具进行本地验证(`composer install`,`php tempest data:generate`,`php tempest data:validate`)。JSON输出必须按URL路径分组,并按日期排序。 提交将在一台专用服务器(Intel Digital Ocean Droplet,2vCPU,1.5GB RAM)上进行基准测试,并启用特定的PHP扩展。前三名最快、*原创*的解决方案将获得PhpStorm和Tideways赞助的奖品,包括其产品的许可证。 结果将在`leaderboard.csv`中跟踪。人工验证和单次提交运行确保公平比较。鼓励参与者tag @brendt 或 @xHeaven 以获得支持或查询基准测试状态。

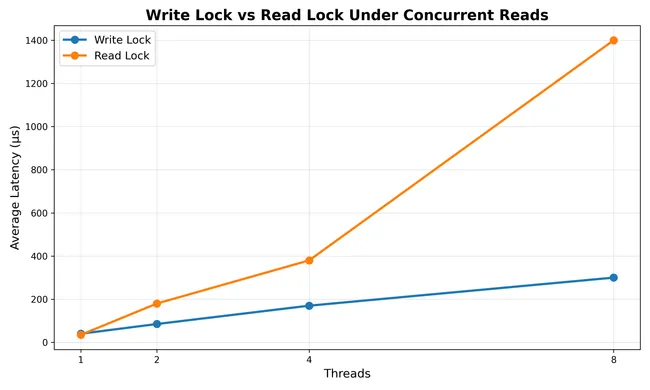

## 张量缓存中的读写锁性能悖论

在 Rust 中对高性能张量缓存进行基准测试时,结果令人惊讶:对于 Apple Silicon M4 硬件上的高读取负载,`RwLock` 的性能明显 *差* (~5 倍) 于 `Mutex`。这与通常认为 `RwLock` 允许多个并发读取,从而提高吞吐量的观点相矛盾。

问题源于“缓存行乒乓”。即使是读取操作也需要对读取计数器进行原子递增,迫使核心不断地使同一缓存行失效并获取。在极快的缓存查找(纳秒级)的背景下,这种开销超过了并发读取的好处。`Mutex` 虽然一次只允许一个线程,但通过授予独占访问权来避免这种竞争。

关键要点是,在选择锁定策略时要 **分析硬件性能**。对于短的关键段,`RwLock` 的原子操作开销可能是有害的。解决方案包括分片缓存以减少锁竞争,或者如果读取操作非常快,则直接使用 `Mutex`。`RwLock` 在读取部分很大或写入不频繁时仍然很有价值,但仔细考虑和分析至关重要。

## 张量缓存中的读写锁性能悖论

在 Rust 中对高性能张量缓存进行基准测试时,结果令人惊讶:对于 Apple Silicon M4 硬件上的高读取负载,`RwLock` 的性能明显 *差* (~5 倍) 于 `Mutex`。这与通常认为 `RwLock` 允许多个并发读取,从而提高吞吐量的观点相矛盾。

问题源于“缓存行乒乓”。即使是读取操作也需要对读取计数器进行原子递增,迫使核心不断地使同一缓存行失效并获取。在极快的缓存查找(纳秒级)的背景下,这种开销超过了并发读取的好处。`Mutex` 虽然一次只允许一个线程,但通过授予独占访问权来避免这种竞争。

关键要点是,在选择锁定策略时要 **分析硬件性能**。对于短的关键段,`RwLock` 的原子操作开销可能是有害的。解决方案包括分片缓存以减少锁竞争,或者如果读取操作非常快,则直接使用 `Mutex`。`RwLock` 在读取部分很大或写入不频繁时仍然很有价值,但仔细考虑和分析至关重要。

Event Horizon Labs是一家位于旧金山的初创公司,由来自Citadel、Jump Trading和顶尖大学的专家创立,正在构建**用于自主AI研究和问题解决的基础设施**。他们认为下一次重大的AI进展不在于更好的模型,而在于利用这些模型的系统。 目前专注于金融市场,因为该市场反馈迅速且结果明确,团队正在开发一个完全自主的系统——协调器、代理和知识库,该系统已经能够识别和扩展盈利的交易策略。 他们正在寻找**创始工程师**来构建这个平台,重点领域包括分布式系统、计算调度、数据管道、代理可观察性以及低延迟交易。该职位需要精通Python、Go、Kubernetes和流数据技术。这是一个需要到岗工作的职位,提供有竞争力的薪资和大量股权。

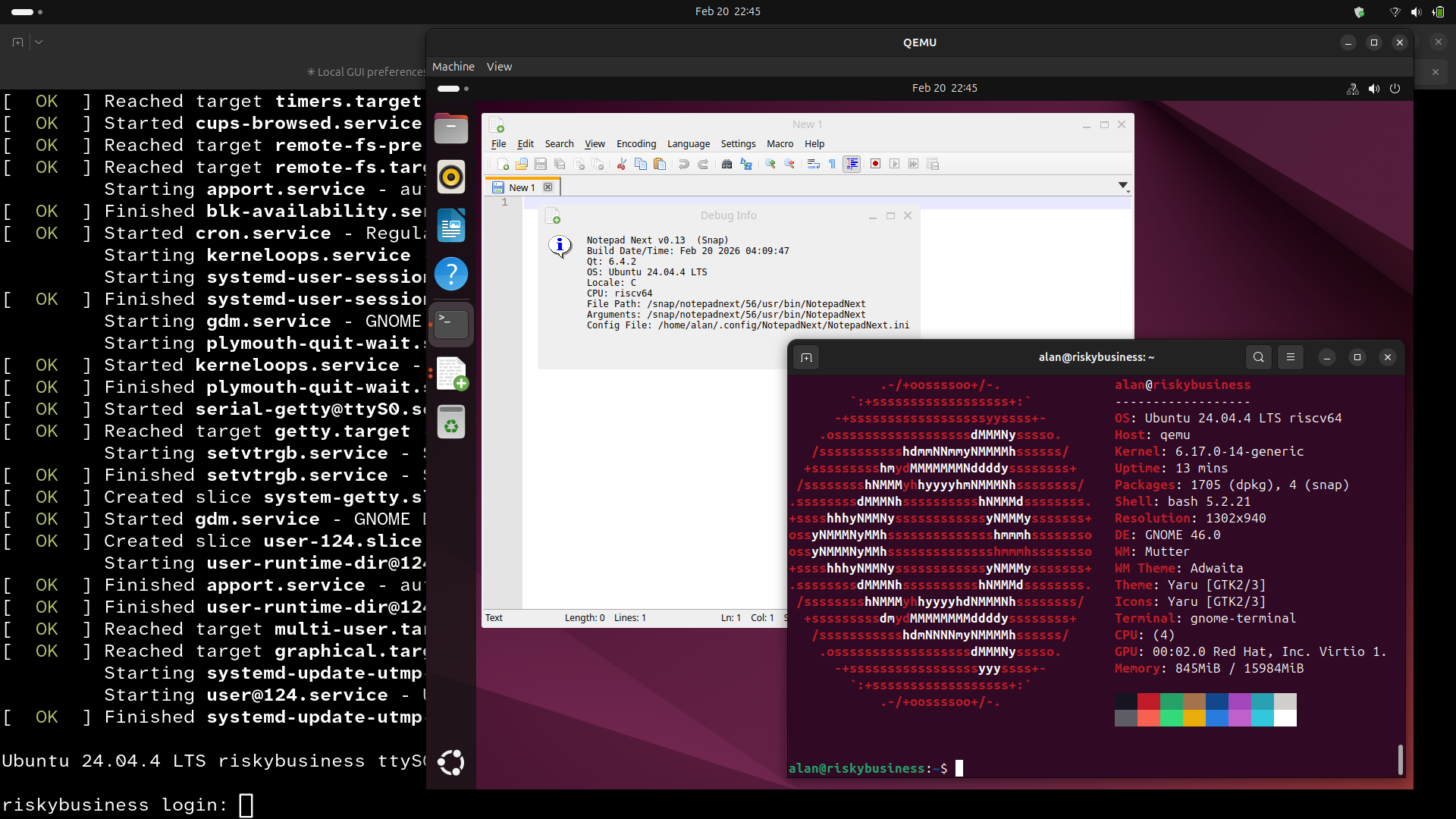

## 通过 QEMU 对 RISC-V Snap 进行测试

作者希望在 RISC-V 架构上测试他们的 snap(软件包),但缺乏必要的硬件。尽管 RISC-V 感觉像一项很有前途的未来技术,但能够运行最新 Ubuntu (25.10) 的可用板仍然要等到一年多以后,因为指令集架构规范 (RVA20 与 RVA23) 仍在不断发展。

与其购买过时的硬件,他们成功地在 ThinkPad 上使用 QEMU 设置了一个 RISC-V 虚拟机。虽然由于 CPU 模拟,虚拟机比原生执行速度慢得多,但它让他们确认了他们的 snap,Notepad Next,在该架构上运行正常。

这次经历凸显了他们需要审计近 50 个 snap 以确保其 RISC-V 兼容性。目前大多数仅针对 amd64,而其他 snap *应该* 可以为 RISC-V 构建,但需要进一步调查。作者计划解决这个问题,旨在在其 snap 产品组合中支持更多架构。

目前,QEMU 提供了一个可行的、免费的解决方案,用于基本的 RISC-V 测试,提供了一个“合理性检查”,以确保 snap 在 2026 年更强大、更容易获得的 RISC-V 硬件到来之前按预期运行。

## 通过 QEMU 对 RISC-V Snap 进行测试

作者希望在 RISC-V 架构上测试他们的 snap(软件包),但缺乏必要的硬件。尽管 RISC-V 感觉像一项很有前途的未来技术,但能够运行最新 Ubuntu (25.10) 的可用板仍然要等到一年多以后,因为指令集架构规范 (RVA20 与 RVA23) 仍在不断发展。

与其购买过时的硬件,他们成功地在 ThinkPad 上使用 QEMU 设置了一个 RISC-V 虚拟机。虽然由于 CPU 模拟,虚拟机比原生执行速度慢得多,但它让他们确认了他们的 snap,Notepad Next,在该架构上运行正常。

这次经历凸显了他们需要审计近 50 个 snap 以确保其 RISC-V 兼容性。目前大多数仅针对 amd64,而其他 snap *应该* 可以为 RISC-V 构建,但需要进一步调查。作者计划解决这个问题,旨在在其 snap 产品组合中支持更多架构。

目前,QEMU 提供了一个可行的、免费的解决方案,用于基本的 RISC-V 测试,提供了一个“合理性检查”,以确保 snap 在 2026 年更强大、更容易获得的 RISC-V 硬件到来之前按预期运行。

丹麦正在积极地从微软产品转向开源软件,如LibreOffice,旨在实现“数字主权”并减少对美国科技公司的依赖。数字部下个月将过渡超过一半的员工,并在年底前完成迁移,这得益于成本节约和对市场支配地位的担忧。 这一举措紧随哥本哈根和奥胡斯等城市的类似决定,并符合更广泛的欧洲趋势。德国的石勒苏益根州也在放弃Microsoft Office,转而使用LibreOffice,并用Open-Xchange替代Outlook,计划完全迁移到Linux。 这一转变部分源于过去的政治紧张和数据保护问题,尤其是在特朗普总统任期内。丹麦数字部保留在出现挑战时恢复使用微软的权利,但这一转变代表着朝着更大的数字独立性和对其自身技术基础设施的控制迈出的重要一步。

## Claude 远程控制:摘要 Claude 的远程控制功能(Pro 和 Max 计划可用,Team/Enterprise 计划不可用)让您可以在不同设备之间无缝继续编码会话——从桌面到手机或另一台电脑。与在云端运行的 Claude Code Web 版本不同,远程控制*完全*在您的机器上运行,访问您的本地文件、工具和环境。 要使用它,请通过命令行启动会话 (`claude remote-control` 或在现有会话中使用 `/remote-control`)。这将生成一个 URL 或二维码,以便使用 claude.ai/code 或 Claude 移动应用程序从其他设备连接。如果会话中断,会自动重新连接。 **主要优势:**完全访问您的本地环境,在不同设备之间同步对话,即使网络出现问题也能继续工作。 远程控制非常适合进行中的本地项目,而 Claude Code Web 版本更适合快速任务或处理尚未克隆的仓库。请记住,运行会话的终端必须保持打开状态,并且长时间的网络中断将终止会话。